"高效率去重"这个短语如果指的是去除重复内容,以下是一些高效率去重的方法:

1. 使用文本去重工具:市面上有很多在线或离线的文本去重工具,如Turnitin、Copyscape等,它们可以帮助检测和去除重复内容。

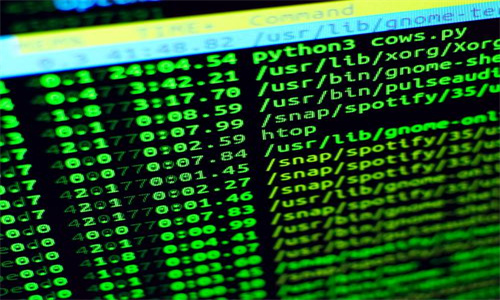

2. 编程方法:如果你熟悉编程,可以使用Python、Java等编程语言编写脚本来自动化去重过程。例如,Python的`difflib`库可以用来比较和找出相似或重复的文本。

3. 数据库去重:如果数据存储在数据库中,可以利用SQL语句中的`DISTINCT`关键字或者`GROUP BY`语句来去除重复记录。

4. 手动审查:对于一些需要特别关注的文本,如原创性文章,可能需要手动审查和去重。

以下是一个简单的Python示例,展示如何使用`difflib`库来找出两个字符串之间的相似度:

```python

import difflib

def find_similarity(str1, str2):

return difflib.SequenceMatcher(None, str1, str2).ratio()

示例

text1 = "高效率去重,是信息处理的重要步骤。"

text2 = "信息处理中的去重工作,要求高效率。"

similarity = find_similarity(text1, text2)

print(f"相似度: {similarity